Crawl budget to pojęcie, które już na dobre zagościło w słowniku działań internetowych. W tym artykule skupimy się na tym czym jest crawl budget, jaki ma związek z adresami URL oraz czy i jak może wpływać na SEO.

- Sebastian Kardyś

- CEO, Digital Marketing Konsultant Od blisko 10 lat pomagam firmom w rozwoju, z wykorzystaniem możliwości, jakie daje internet. Jestem założycielem trzech marek działających na polskim rynku, a w trakcie swojej kariery miałem okazję pracować i doradzać takim markom jak: Big Activ, Schneider Electric, Alstom, Librus, Politechnika Śląska, TSR Poland, Axell Group, Gerlach, Uber czy Almatur i jeszcze wiele innych :). Aktualnie mocno zaangażowany w nowy start up z europejskimi aspiracjami.

- 4 marca, 2022

CEO, Digital Marketing Konsultant

Od blisko 10 lat pomagam firmom w rozwoju, z wykorzystaniem możliwości, jakie daje internet. Jestem założycielem trzech marek działających na polskim rynku, a w trakcie swojej kariery miałem okazję pracować i doradzać takim markom jak: Big Activ, Schneider Electric, Alstom, Librus, Politechnika Śląska, TSR Poland, Axell Group, Gerlach, Uber czy Almatur i jeszcze wiele innych :). Aktualnie mocno zaangażowany w nowy start up z europejskimi aspiracjami.

- 4 marca, 2022

Spis Treści

|Crawl budget – co to?

W czasach, w których ludzie głównie szukają informacji w Internecie, warto zadbać o szybką i sprawną indeksację strony, aby witryna mogła pokazać się w wynikach wyszukiwania. Właśnie dlatego Googleboty nieustannie przeczesują sieć i sprawdzają witryny pod kątem wartościowych treści. Google wysyła swoje boty, aby scrawlować strony internetowe. Gdy ten proces zostanie wykonany, strona będzie znajdować się w indeksie Google, co oznacza, że strona będzie wyświetlać się użytkownikom sieci.

Crawl budget to inaczej budżet indeksowania witryny, czyli poziom uwagi, jaki wyszukiwarki poświęcają danej stronie. Wlicza się w to również czy mogą indeksować stronę oraz z jaką regularnością będzie się to działo.

Nie zmienia to jednak faktu, że Google ma swój pewny limit i przeznacza swoje środki na przeczesywanie Internetu, dlatego właśnie crawl budget jest rozdrabniany na każdą podstronę serwisu.

Żeby dobrze zrozumieć crawl budget, należy wiedzieć, na czym dokładnie się opiera, a jest to głównie:

- Crawl Rate Limit – limit indeksowania, który został wprowadzony, aby Google nie sprawdzał zbyt wielu stron w zbyt krótkim czasie. Ma to na celu przede wszystkim zapobiec ewentualnym przeciążeniom serwera witryny. Crawl rate limit powstrzymuje Google od wysyłania zbyt wielu zapytań, które mogłyby spowolnić stronę. Ma to również bezpośredni wpływ na crawlowanie strony – im strona jest wolniejsza, tym mniej zapytań od Google do niej trafia. To natomiast sprawia, że Google jest w stanie przeanalizować niewiele stron z danego serwisu. Jeśli szybkość strony jest odpowiednia, to również crawl rate limit wzrasta.

- Crawl Demand – zapotrzebowanie na indeksowanie. Google podkreśla wielokrotnie, że strony z popularnym i aktualnym contentem są bardziej cenione. To samo dotyczy crawl demand – jeśli zapotrzebowanie na indeksowanie jest niskie, wtedy Googlebot będzie unikał crawlowania. Wysokość tego czynnika zależy od ogólnej popularności witryny, aktualności oraz wartościowego contentu.

|Jaki wpływ na SEO ma crawling budget?

Termin ten został wprowadzony przez branżę SEO w celu pokazania szeregu powiązanych koncepcji i systemów, które są czynnikami wpływającymi na to ile i które konkretnie strony/podstrony będą zaindeksowane.

Każdy, kto prowadzi działalność w Internecie, chciałby, aby jego witryna była zaindeksowana jak najszybciej i nikt nie chce tracić potencjalnego ruchu ze strony, które nie zostały jeszcze scrawlowane. Nie ma jednak sensu na siłę zmuszać roboty do powrotu na stronę. Najlepsze w takiej sytuacji może być po prostu dbanie o jakość serwisu, nie tylko dla użytkownika, ale również dla robotów.

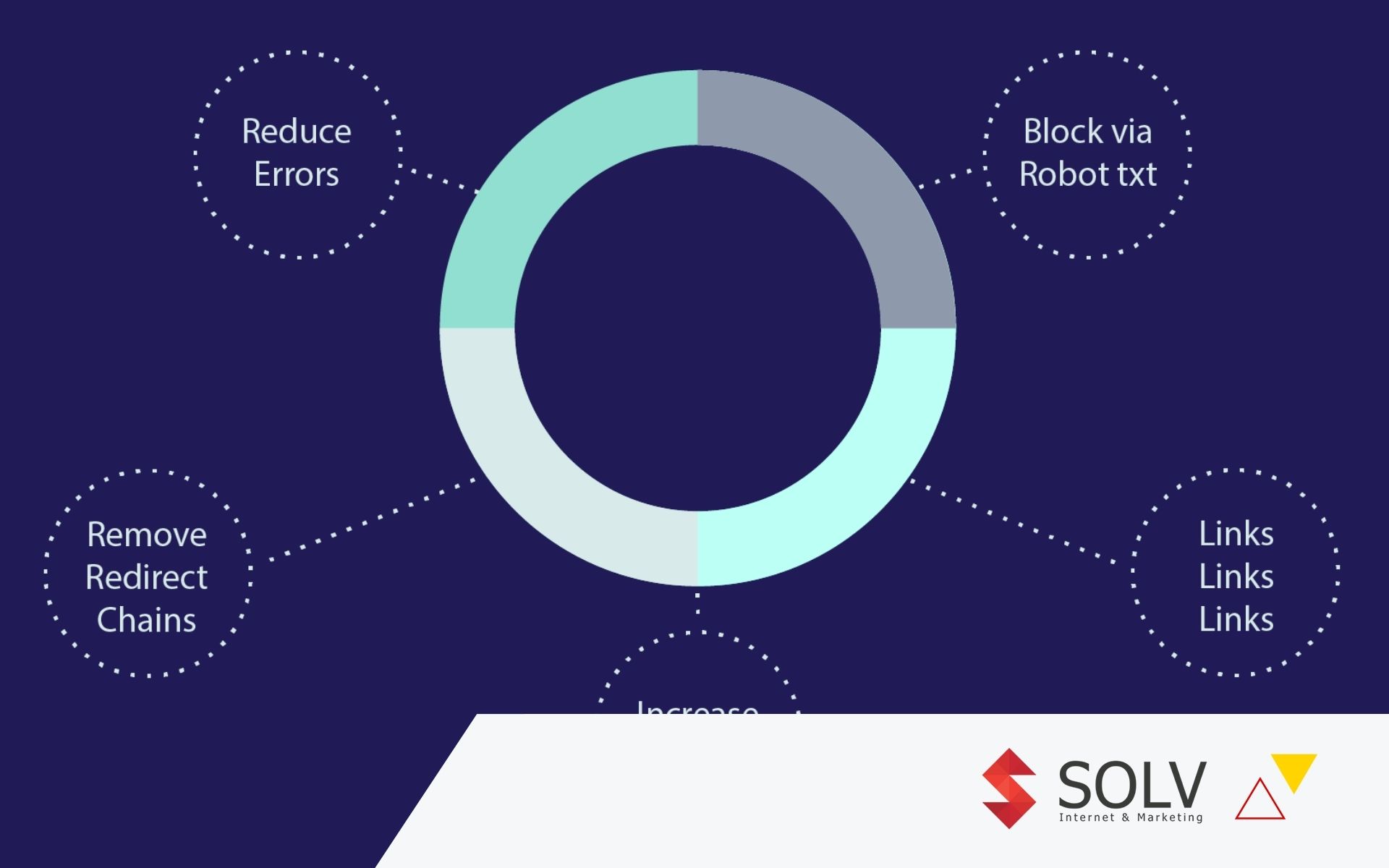

Zatem co warto zrobić? Przede wszystkim należy ustalić prędkość strony. Jak zostało wspomniane wyżej – im strona wolniejsza, tym bardziej może pojawić się problem z prędkością indeksowania. Kolejnym ważnym czynnikiem wpływającym na crawl budget są przekierowania. Dzięki dobrze zrobionym przekierowaniom robot od razu zobaczy, na jaką stronę powinien się skierować i na jakiej się skupić. Dobrze zrobione przekierowanie nie będzie zatem problemem. Problematyczne mogą okazać się jednak błędy 404. Dla robota jest to znak, że jakieś połączenie między stronami zostało przerwane. To oznacza, że albo robot opuści stronę, albo zmarnuje zbyt wiele czasu na szukaniu odnośnika, przez co zostanie zmarnowany crawl budget.

Aby cały proces był jeszcze bardziej wydajny, warto postawić na linkowanie wewnętrzne. To właśnie dzięki temu, roboty wiedzą jakie strony są ze sobą powiązane oraz o wiele łatwiej i szybciej poruszają się po stronie – zresztą dla użytkownika to również sama korzyść. Linkując do np. najważniejszej z podstron, dajemy robotom do zrozumienia, że to ta właśnie strona powinna zostać sprawdzona i ponownie zaindekowana oraz to tą konkretną podstroną należy się zająć w pierwszej kolejności.

Równie ważne, na co warto zwrócić uwagę to głębokość osadzenia witryny oraz kierujące do niej linki. Jeśli jakaś strona jest osadzona głęboko w naszym serwisie, np. została dodana bardzo dawno lub też nie jest powiązana mocno tematycznie z innymi stronami, może być o wiele mniej widoczna dla użytkownika oraz samego robota. Wtedy warto “wyciągnąć” stronę z tych głębin treści i pokazać robotom, że istnieje. Całkowicie należy pozbyć się linków, do których nie prowadzi żaden odnośnik tak zwane orphan URL – w takim przypadku warto stronę podlinkować tematycznie powiązanym artykułem, co stworzy łańcuch, po którym boty będą mogły się poruszać.

|Czego unikać, żeby nie marnować naszego budżetu internetowego?

Napisaliśmy wyżej, co warto zrobić, aby roboty poruszały się sprawnie po stronie i po części czego unikać. Są jednak jeszcze inne aspekty, na które należy zwrócić uwagę przy poprawie crawl budgetu oraz kondycji strony.

- plik sitemap.xml – jest to zbiór adresów witryny, które znajdują się na danej stronie. Ten plik jest jedną z wytycznych dla robotów, jakie strony powinny zostać sprawdzone i zaindeksowane. Jeśli dodamy nową podstronę, kategorię czy też artykuł blogowy warto w takiej sytuacji zaktualizować ten właśnie plik i ponownie “powiadomić” o tym Google poprzez GSC, w sekcji Mapy witryny.

- plik robots.txt – jest to plik, do którego dostęp ma każdy robot, o ile nie zabronimy wstępu. Właśnie na zabranianie dostępu należy zwrócić szczególną uwagę. Jeśli chcemy zabronić dostępu do crawlowania strony należy wybrać dokładnie jakie roboty nie powinny pojawiać się na naszej stronie. Blokując dostęp wszystkim robotom, czyli tym od Google również doprowadzamy do sytuacji, w której w konsekwencji Googleboty nie mają dostępu do naszej strony i nie mogą jej scrawlować. Może to zatem doprowadzić do problemów z indeksowaniem strony oraz spadkiem w pozycjach wyszukiwania.

Omów z nami swój pomysł

Napisz do nas

|Z jakich narzędzi korzystać, aby sprawdzić błędy?

Najbardziej podstawowym narzędziem będzie Google Search Console, gdzie w łatwy i przejrzysty sposób można sprawdzić, które strony są zaindeksowane i czytelne dla robotów. Dodatkowo dostaniemy informację o błędach w indeksowaniu i co należy zrobić, aby dany błąd usunąć. Co najważniejsze, bez większych problemów możemy przesłać aktualną mapę witryny i sprawdzić, czy została poprawnie dodana. Sprawdzimy również ilość linków wewnętrznych i na której stronie jest ich najwięcej.

Narzędzie, dzięki któremu dowiemy się o błędach nie tylko 404, przekierowaniach czy też wygenerujemy automatyczną site mapę to Screaming Frog. W tym narzędziu możemy również sprawdzić strukturę strony, głębokość osadzenia danych podstron czy znaleźć sierotki – linki, do których nie prowadzi żaden odnośnik. Aby jednak móc korzystać z tego narzędzia, musi mieć ono dostęp do strony, czyli nie może być blokowane przez robots.txt lub przez plik .htaccess.

|Podsumowanie

Warto, nawet przy mniejszych serwisach brać pod uwagę crawl budget oraz te kilka wytycznych, które zostały opisane w tym artykule. Zaindeksowana strona to po prostu korzyść dla naszego serwisu, o którą zawsze warto dbać. Mając jeszcze dodatkowe narzędzia, cały proces będzie łatwiejszy do zrealizowania, a dzięki temu będziemy mieć pewność, że struktura serwisu jest prawidłowa.